요즘 AI를 이용한 바이브 코딩을 유행하고 있습니다. 저도 gemini-cli를 이용해 이런 방식으로 코딩을 해봤는데요.

다만 비용 문제나 프라이버시·보안상의 이유로, 온라인 AI 서비스에 코드를 입력하는 것이 꺼려질 수 있습니다.

그래서 gemini-cli나 claude-code와 비슷한 환경을 로컬에서 구현할 방법을 찾아봤습니다.

최근 공개된 OpenAI의 오픈소스 모델 gpt-oss를 로컬 AI 코딩 어시스턴트로 사용해보기로 했습니다.

처음에는 VS Code + Cline 조합을 시도했는데 gpt-oss로는 제대로 작동하지 않았습니다.

이후 몇 가지 방법을 더 시도해본 결과, 제 PC에서 제대로 작동한 건 Ollama + Aider 조합이었습니다.

아래에 설치 방법과 실행 결과를 정리했습니다.

1. Ollama 설치

로컬에서 LLM(대형 언어 모델)을 사용할 수 있게 해주는 프로그램입니다.

Ollama 다운로드 페이지에서 운영체제에 맞는 버전을 설치하세요.

2. Ollama에서 gpt-oss 모델 다운 받기

설치된 Ollama에서 쓸 모델을 다운 받아야 합니다. gpt-oss 20b 모델을 이용하겠습니다. 터미널을 열고 입력합니다.

저는 CMD를 이용하여 진행하였습니다. (윋도우 + R 누르고 cmd 입력)

ollama pull gpt-oss:20b

3. Aider 설치

Aider는 gemini-cli나 claude-code처럼 터미널 기반으로 AI를 이용해 코드를 작성할 수 있는 도구입니다.

아래 명령어들을 순서대로 터미널에 입력합니다. 컴퓨터에 파이썬이 설치되어 있어야 합니다.

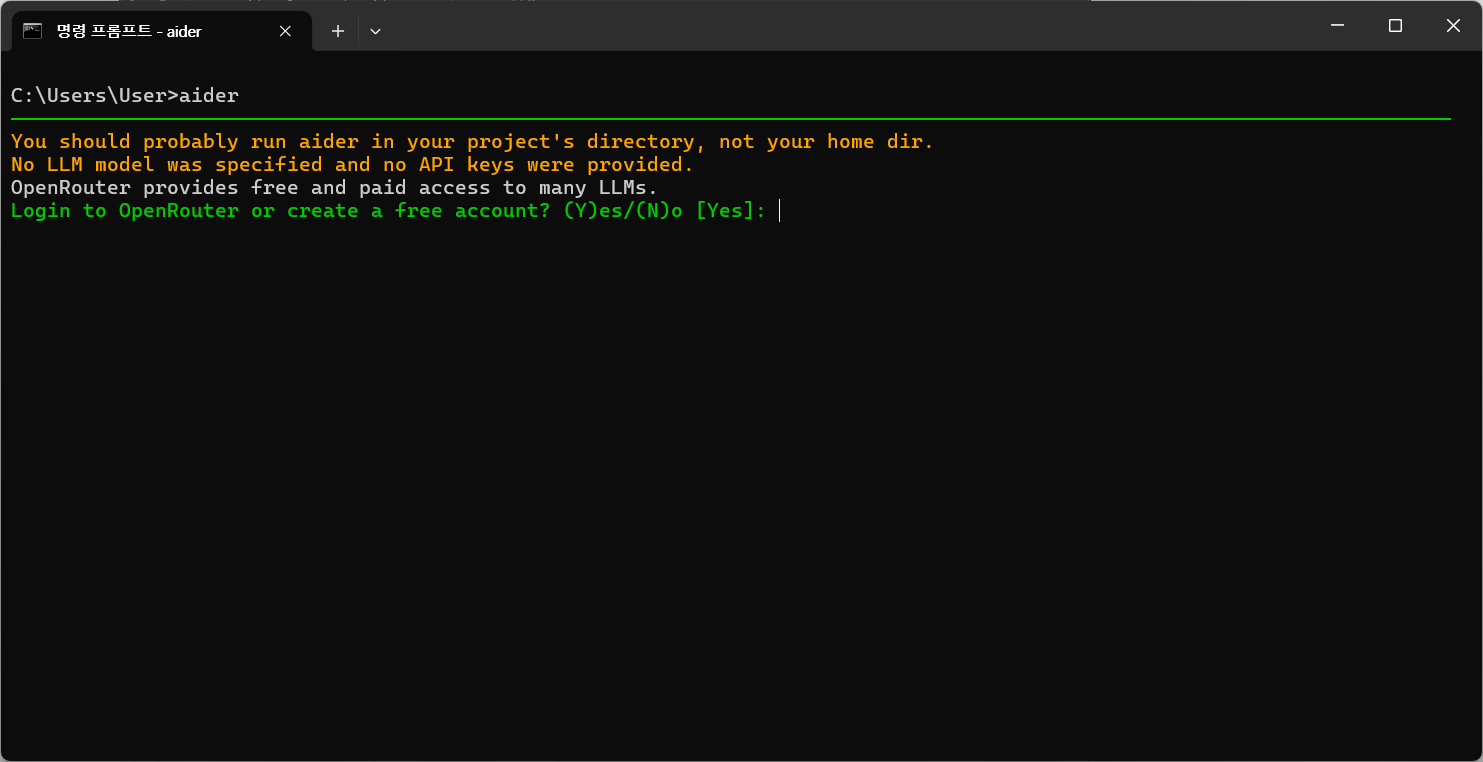

설치 후 aider 명령이 동작하면 정상 설치된 것입니다. 작동하지 않는다면 터미널을 껐다가 다시 켜보세요.

더 자세한 설치 과정을 보고 싶으면 Aider 공식 문서를 확인하세요.

python -m pip install aider-install

aider-install

4. Aider용 Ollama 전역변수 설정

Aider에서 Ollama를 쓰려면 전역변수를 설정해야 합니다.

맥이나 리눅스는 export, 윈도우는 setx 명령어를 사용하면 됩니다. setx 명령어는 입력 후에 터미널을 재시작해야 됩니다.

export OLLAMA_API_BASE=http://127.0.0.1:11434 # Mac/Linux

setx OLLAMA_API_BASE http://127.0.0.1:11434 # Windows, setx 입력 후에는 터미널을 재시작

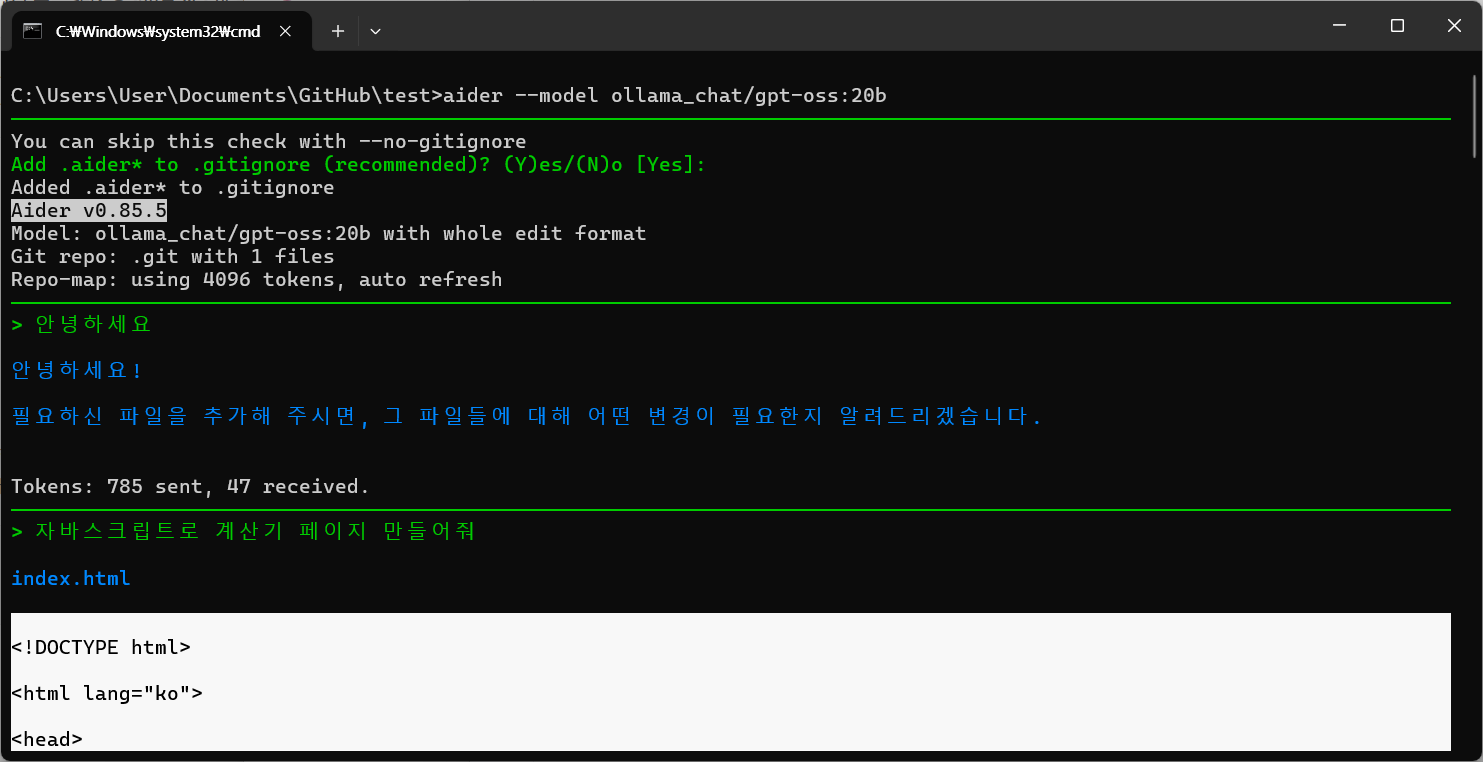

5. Ollama로 Aider 실행

사용할 때는 Ollama를 실행해둬야 합니다.

Ollama를 실행하고 다시 터미널로 이동합니다.

수정하려는 프로젝트 폴더 안에서 aider 명령어를 입력합니다.

cd C:\projects\project

aider --model ollama_chat/gpt-oss:20b

6. gpt-oss 실행 결과

RTX 4090에서 실행했는데 속도도 괜찮고 한국어도 잘 나옵니다.

자바스크립트로 계산기를 만들어 달라고 하니 한 번에 만들어주었습니다.

많은 테스트를 해보진 않았는데, 복잡한 요구를 하면 Gemini나 Claude 같은 유료 AI들보다 성능이 떨어지는 거 같긴 합니다.

'AI 정보' 카테고리의 다른 글

| 양자화 의미 / 양자 모델 추천 (Q5_K, Q5_K_S, Q5_K_M 차이) (0) | 2025.03.03 |

|---|---|

| 로컬 PC에 DeepSeek 설치해서 사용하는 법 (Ollama, ChatBox 사용) (1) | 2025.01.28 |

| 진짜 사람처럼 자연스러운 AI TTS 추천 - Hailuo Audio (0) | 2025.01.16 |